Submitted by toniher on

Si esteu preparant un nou lloc web, és habitual que dediqueu un domini separat per al seu desenvolupament abans que es faci públic, i un cop anunciat, també per a portar-hi a termes les proves de noves funcionalitats abans d'incloure res al lloc en producció.

Amb això podeu pensar, equivocadament, que si no distribuïu cap adreça del vostre lloc web de desenvolupament (ex.: dev.example.com) i ningú l'enllaça, que el vostre lloc web no s'escamparà a cercadors com el Google. Cras error. En aquest vídeo podeu veure una explicació de perquè cal ser més cautelós i com eliminar llavors els URL dels resultats de les cerques.

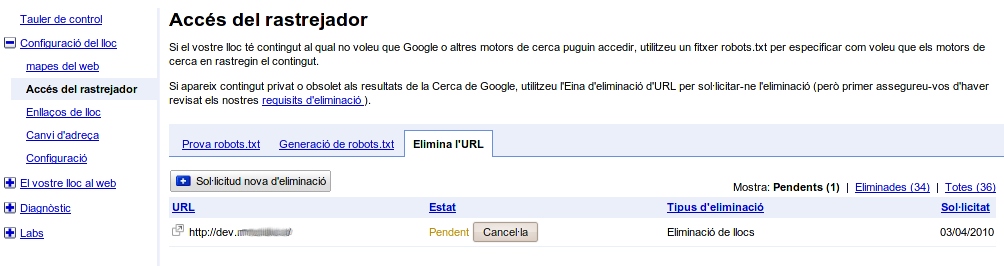

Com ho fem doncs per protegir tot el contingut del directori d'un lloc web (http://dev.example.com), però al mateix temps fer accessible el fitxer robots.txt (http://dev.example.com/robots.txt), on indiquem que no volem que s'indexi cap més pàgina? Pensem que si protegim completament el directori —amb autenticació HTTP—, el rastrejador del cercador tampoc podrà arribar al robots.txt. Això provocarà que els resultats de la cerca no desapareguin ràpidament, i hàgim d'eliminar-los un a un des del tauler de sol·licituds d'eliminacions del Google. Aquesta darrera possibilitat pot ser un malson si són moltes les pàgines afectades.

La solució més polida és, doncs, mirar de protegir tot menys el fitxer robots.txt precisament, on hi hem d'especificar que no volem indexar res del nostre lloc.

User-agent: *

Disallow: /

A continuació enganxo una mica de configuració d'exemple de com fer-ho des de l'Apache i el Nginx respectivament.

Apache

DocumentRoot /camí/web

<Directory /camí/web/>

... Més teca ...

AuthUserFile /camí/robots/.htpasswd

AuthName Protecció

AuthType Basic

require user Propietari

</Directory>

Alias /robots.txt /camí/robots/robots.txt

<Directory /camí/robots>

... Més teca ...

</Directory>

Nginx

root /camí/web;

location = /robots.txt {

root /camí/web/robots;

}

location / {

... més teca ..

auth_basic "Protecció";

auth_basic_user_file /etc/nginx/htpasswd/default;

}

Per a utilitzar les eines per a webmestres del Google podeu optar per utilitzar un html per a verificar el lloc web. Aquest caldria que també estigués desprotegit. Només cal fer el mateix que amb el robots.txt.

Un cop fet tot això, amb el Google ja es pot demanar eliminar la indexació del lloc web de desenvolupament:

Comments

Pingback

[...] Eliminació de la indexació d'un lloc web que voleu protegir | El Cau del Drac www.cau.cat/blog/eliminacio_de_la_indexacio_dun_lloc_web_que_voleu_protegir – view page – cached Personal blog of Toni Hermoso Pulido Filter tweets [...]